Votre panier est vide.

Certains articles de veille peuvent faire l'objet de traduction automatique.

Un chercheur en sécurité a reçu une prime de bogue de 107 500 $ pour avoir identifié des problèmes de sécurité dans les haut-parleurs intelligents Google Home qui pourraient être exploités pour installer des portes dérobées et les transformer en dispositifs d’écoute électronique.

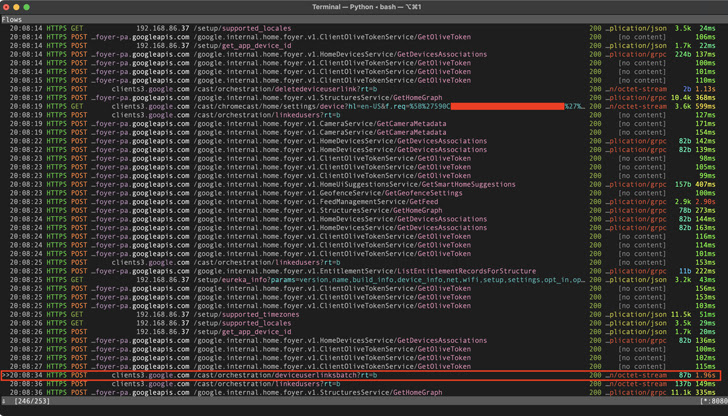

Les failles « ont permis à un attaquant à proximité sans fil d’installer un compte » de porte dérobée « sur l’appareil, lui permettant d’envoyer des commandes à distance via Internet, d’accéder à son flux de microphone et de faire des requêtes HTTP arbitraires dans le LAN de la victime », a déclaré le chercheur. , qui s’appelle Matt, divulgué dans un article technique publié cette semaine.

En faisant de telles demandes malveillantes, non seulement le mot de passe Wi-Fi pourrait être exposé, mais également fournir à l’adversaire un accès direct à d’autres appareils connectés au même réseau. Suite à la divulgation responsable du 8 janvier 2021, les problèmes ont été résolus par Google en avril 2021.

Le problème, en un mot, a à voir avec la façon dont l’architecture logicielle de Google Home peut être exploitée pour ajouter un compte d’utilisateur Google escroc à l’appareil domotique d’une cible.

Dans une chaîne d’attaque détaillée par le chercheur, un acteur malveillant cherchant à espionner une victime peut inciter l’individu à installer une application Android malveillante qui, lors de la détection d’un appareil Google Home sur le réseau, émet des requêtes HTTP furtives pour lier le compte d’un attaquant. à l’appareil de la victime.

En prenant les choses un cran plus haut, il est aussi ressorti qu’en mettant en scène un Attaque de désauthentification Wi-Fi pour forcer un appareil Google Home à se déconnecter du réseaul’appareil peut être amené à entrer en « mode configuration » et à créer son propre réseau Wi-Fi ouvert.

L’auteur de la menace peut ensuite se connecter au réseau de configuration de l’appareil et détails de la demande comme le nom de l’appareil, cloud_device_id et le certificat, et les utiliser pour lier leur compte à l’appareil.

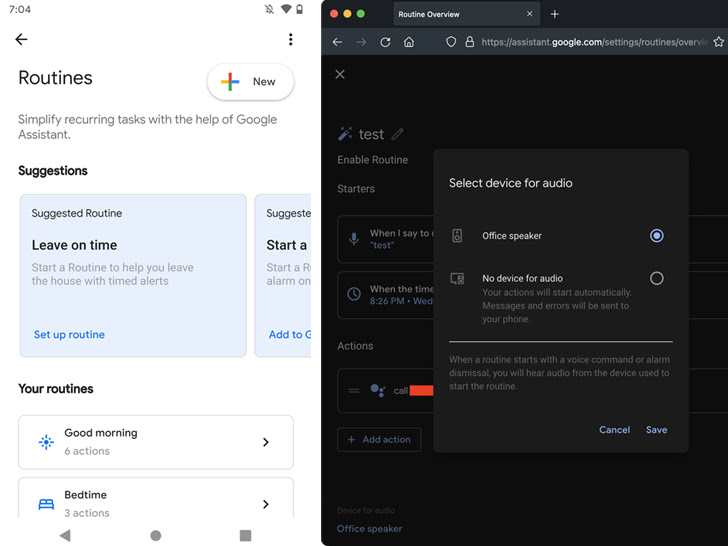

Indépendamment de la séquence d’attaque employée, un processus de liaison réussi permet à l’adversaire de profiter de Routines Google Home baisser le volume à zéro et appeler un numéro de téléphone spécifique à tout moment pour espionner la victime via le microphone de l’appareil.

« La seule chose que la victime peut remarquer, c’est que les LED de l’appareil deviennent bleues fixes, mais elle supposerait probablement qu’il met à jour le firmware ou quelque chose comme ça », a déclaré Matt. « Pendant un appel, les LED ne clignotent pas comme elles le font normalement lorsque l’appareil écoute, il n’y a donc aucune indication que le microphone est ouvert. »

De plus, l’attaque peut être étendue pour effectuer des requêtes HTTP arbitraires au sein du réseau de la victime et même lire des fichiers ou introduire des modifications malveillantes sur l’appareil lié qui seraient appliquées après un redémarrage.

Ce n’est pas la première fois que de telles méthodes d’attaque sont conçues pour espionner secrètement des cibles potentielles via des dispositifs activés par la voix.

En novembre 2019, un groupe d’universitaires a divulgué une technique appelée Light Commands, qui fait référence à une vulnérabilité des microphones MEMS qui permet aux attaquants d’injecter à distance des commandes inaudibles et invisibles dans des assistants vocaux populaires tels que Google Assistant, Amazon Alexa, Facebook Portal et Apple Siri. utilisant la lumière.

Poster un commentaire